Apesar do repentino sucesso do Chat GPT, o chatbot ainda falha ao consumidor em muitos aspetos, mas por causa de uma pequena peça de hardware, que até Elon Musk considerou ser “mais difícil de arranjar do que drogas”, pode vir a falhar também ao seu criador — a OpenAI.

Modelos de linguagem como o Chat GPT estão em clara ascensão e os investimentos nas empresas de tecnologia que os criam continuam a aumentar.

No entanto, o novo IA generativo pode ter um “calcanhar de Aquiles” muito simples que pode representar um problema a longo prazo — sem monetização, estes chatbots perdem dinheiro cada vez que são usados, sendo necessárias largas quantias monetárias para os gerir.

Não estão planeados, segundo o The Washington Post, quaisquer modelos de remuneração rentáveis para um serviço que conta com cada vez mais utilizadores — e que por sua vez custam cada vez mais às empresas-mãe.

O atual modelo de subscrição do Chat GPT Pro, que pode ser desfrutado a partir de 20 dólares mensais (18,72€), só permite 25 mensagens a cada três horas, o que demonstra a complexidade do processo de geração de respostas do chatbot.

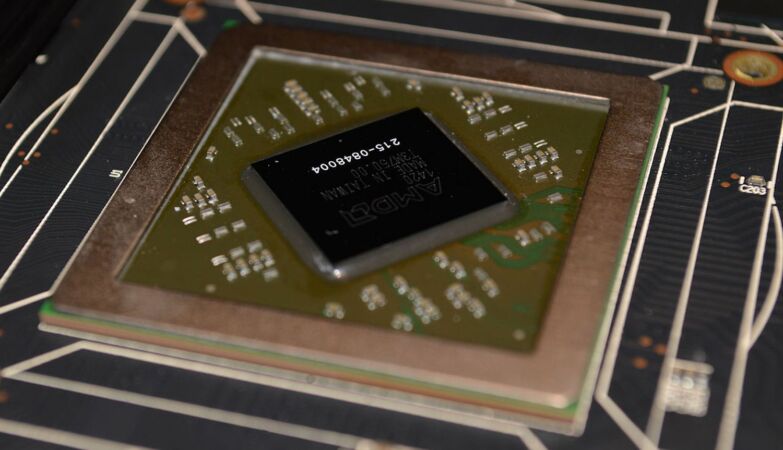

Um simples chip está a atingir o calcanhar

As empresas de IA estão atentas a esta situação, que é agravada pelo facto de as unidades de processamento gráfico (GPU) — chips de computador fundamentais para o processamento — estarem em decréscimo.

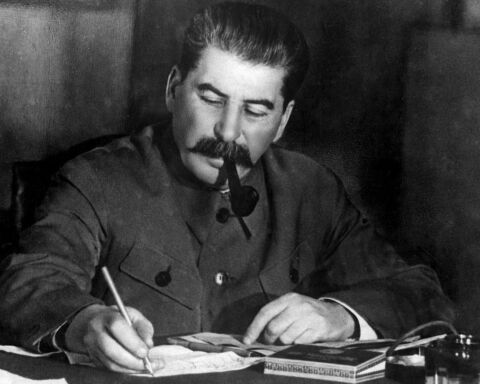

“Estamos com poucos GPU, por isso, quanto menos pessoas usarem os nossos produtos, melhor”, desabafa, surpreendentemente, o CEO da OpenAI, Sam Altman, durante uma audiência no Senado, no mês passado, segundo o The Byte.

Até o CEO da Tesla, Elon Musk, de momento a arquitetar a sua própria startup de IA, já encarou o problema, confessando em conferência do Wall Street Journal no mês passado que “nesta fase, os GPU são consideravelmente mais difíceis de arranjar do que drogas.”

No entanto, tudo aponta para que as empresas continuem a insistir nos modelos de linguagem, uma vez que, apesar das adversidades, continua a ser muito menos dispendiosos do que a mão de obra humana.