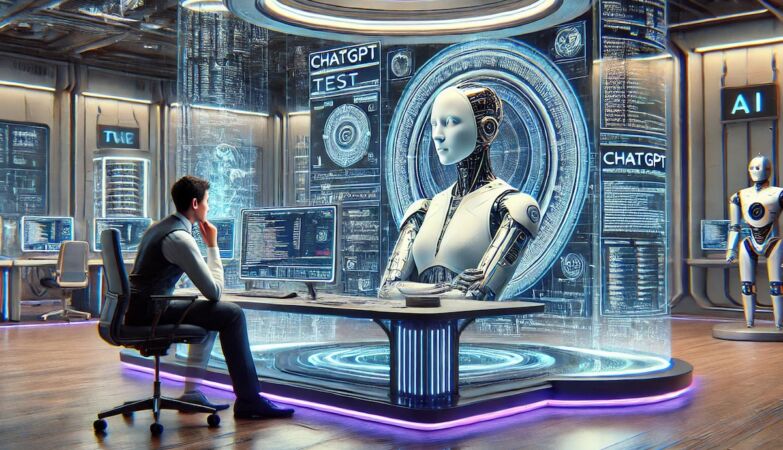

ZAP // Dall-E-2

A inteligência artificial pode ser obrigada a dizer a verdade? Provavelmente, não, mas os criadores de chatbots com grandes modelos de linguagem (LLM) talvez devessem ser legalmente obrigados a reduzir o risco de erros.

“A IA é apenas a IA e, por isso, não tem a obrigação de dizer a verdade”. Será que isto pode ser dito assim, de forma tão simplista?

Uma equipa especialistas em ética que publicou um estudo sobre o tema na Royal Society Open Science, que encoraja as empresas de IA a mudarem o paradigma no que toca às responsabilidades cívicas das IA.

“O que estamos a tentar fazer é criar uma estrutura de incentivos para que as empresas deem maior ênfase à verdade e à exatidão quando criam os sistemas”, explica Brent Mittelstadt, um dos líder das investigação, da Universidade de Oxford, citado pela New Scientist.

Os chatbots LLM, como o ChatGPT, geram respostas de tipo humano às perguntas dos utilizadores, com base na análise estatística de grandes quantidades de texto.

No entanto, apesar de parecerem convincentes, estas ferramentas são muito propensas a erros – conhecidas como “alucinações” – muito fáceis de identificar.

“Temos estes sistemas de IA generativa muito, muito impressionantes, mas eles enganam-se com muita frequência e, tanto quanto podemos compreender o funcionamento básico dos sistemas, não há uma forma fundamental de corrigir isso”, explica Mittelstadt.

Como descreve a equipa, este é um “problema muito grande” para os LLM, especialmente quando são usados em contextos críticos, como decisões governamentais, onde a precisão é essencial.

Seja verdadeira, sra. IA!

Para mitigar o problema, a equipa de investigação propõem que os LLM ajam como humanos ao responder a questões factuais. Para isso devem, desde logo, ser honestos sobre o que sabem e o que não sabem.

Isso envolve admitir incertezas em vez de inventar respostas. Sugere-se, então, que os modelos estabeleçam ligações às fontes e usem a técnica de geração aumentada de recuperação para limitar as alucinações.

A equipa também defende que os LLM utilizados em áreas de alto risco devem ser reduzidos ou as fontes a que podem recorrer devem ser restringidas: “Se tivéssemos um modelo linguístico que quiséssemos utilizar apenas na medicina, talvez o limitássemos de modo a que só pudesse pesquisar artigos académicos publicados em revistas médicas de alta qualidade”.

Brent Mittelstadt também enfatiza a importância de mudar as perceções sobre os LLM, defendendo que se afastem da ideia de que são sempre fiáveis, e que passem mais a ser entendidos como ferramentas auxiliares para factos.

“Se conseguirmos afastar a ideia de que [os LLM] são bons a responder a questões factuais ou, pelo menos, que lhe darão uma resposta fiável a essas questões, e, em vez disso, os virmos mais como algo que o pode ajudar com os factos que lhe traz, isso seria benéfico”, considera investigador.