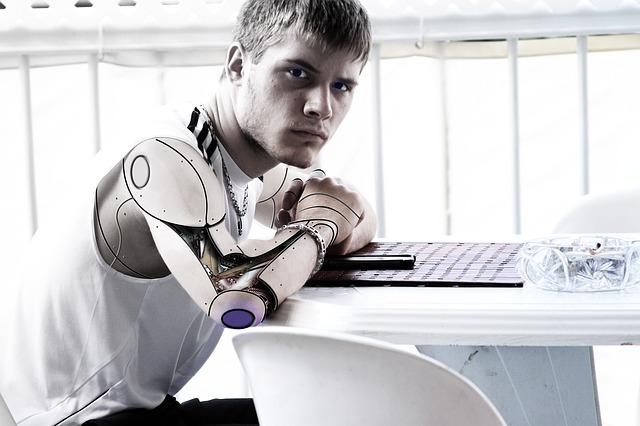

Um relatório preliminar da UNESCO divulgado recentemente avalia as questões éticas relacionadas com o uso de robôs autónomos e suas interacções com seres humanos.

Um painel de especialistas em ética da ciência e tecnologia está a explorar a possibilidade de os robôs se tornarem “máquinas morais”, inclusivamente com direitos legais caso desenvolvam a habilidade de sentir emoções e distinguir entre o certo e o errado.

Num relatório preliminar divulgado em setembro, este grupo de trabalho defendeu que “dependendo dos futuros avanços nesta área, a possibilidade de os robôs desenvolverem emoções e até estatuto moral não deve ser descartada”.

Este grupo faz parte da COMEST, Comissão sobre a Ética do Conhecimento Científico e Tecnológico, o órgão científico consultivo da Organização das Nações Unidas para Educação, Ciência e Cultura, UNESCO.

O documento avalia questões éticas relacionadas com uso de robôs autónomos e como os seres humanos interagem com eles.

Segundo os especialistas, “o rápido desenvolvimento de robôs autónomos altamente inteligentes deve desafiar a classificação actual de seres de acordo com o seu estatuto moral, de forma igual ou até mais profunda que o movimento dos direitos dos animais”.

De acordo com o relatório, supondo que os robôs do futuro se tornem ainda mais sofisticados, talvez até ao ponto de aprenderem com experiências anteriores e se auto-programarem, a natureza dos seus algoritmos deve tornar-se um problema digno de “séria atenção ética e reflexão”.

Sentido de humor, códigos éticos

Embora a maioria dos estudiosos que trabalham com ética dos robôs concorde que eles ainda estão longe de se tornarem “agentes éticos” como os humanos, há especulações de que os robôs possam adquirir, no futuro, características como o sentido de humor – de preferência, diferente do britânico.

Segundo o relatório preliminar, os especialistas até consideram a possibilidade de os humanos virem a ter relações sexuais com robôs ou se apaixonarem por máquinas.

Segundo o documento, a autonomia dos robôs deve crescer de forma a que sua regulação ética se torne necessária.

Isso seria feito através da programação dessas máquinas com códigos éticos criados especificamente para prevenir comportamentos que coloquem em risco os seres humanos ou o meio ambiente.

O estudo, no entanto, levanta uma questão importante: quem deve assumir a responsabilidade ética e legal nos casos de um mau funcionamento de um robô, que acabe por prejudicar de alguma forma os seres humanos?

O documento realça que o campo da robótica ainda é pouco regulado, tanto ética como legalmente, provavelmente por ser uma área de pesquisa relativamente nova e que muda constantemente, cujo impacto no mundo real é difícil de antecipar.

Por fim, os especialistas consideram ser provável que o mau funcionamento nos sofisticados robôs de hoje em dia, como robôs armados utilizados para fins militares ou carros robóticos autónomos que saiam do controle, seja capaz de infligir danos significativos num grande número de pessoas.

A dúvida é, portanto, não apenas se os roboticistas devem respeitar certas normas éticas, mas principalmente se certas normas éticas devem ser programadas nos próprios robôs.

Felizmente, metade do trabalho já está feito há muito tempo pelo escritor Issac Asimov, um dos “três grandes da ficção científica”, que em 1942 idealizou as Três Leis da Robótica que acompanhariam as suas maravilhosas histórias de robôs durante toda a sua carreira.

- Primeira Lei: Um robô não pode ferir um ser humano ou, por inacção, permitir que um ser humano sofra qualquer mal.

- Segunda Lei: Um robô deve obedecer às ordens que lhe sejam dadas por qualquer ser humano, excepto nos casos em que tais ordens entrem em conflito com a Primeira Lei.

- Terceira Lei: Um robô deve proteger a sua própria existência, desde que tal protecção não entre em conflito com a Primeira ou Segunda Leis.

Quase 75 anos depois, mais actuais do que nunca.

AJB, ZAP // Rádio ONU