Não é preciso muito para que o ChatGPT cometa um erro factual. Um exemplo disso foi o teste feito pelo investigador de Ciência de Computação, Jonathan May.

A plataforma de inteligência artificial ChatGPT tem feito manchetes pelas inúmeras aplicações inovadoras que o seu modelo de linguagem pré-treinado oferece.

Mas não é preciso puxar muito por ele para o apanhar em erros factuais — como mostrou recentemente um teste feito pelo investigador de Ciência de Computação Jonathan May.

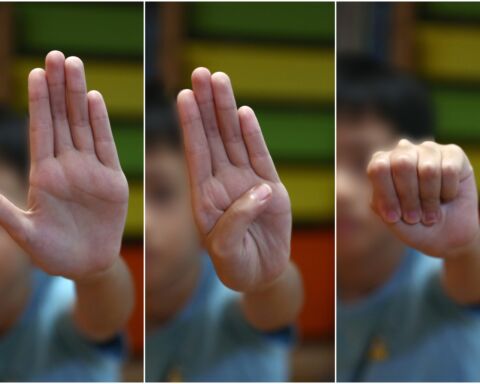

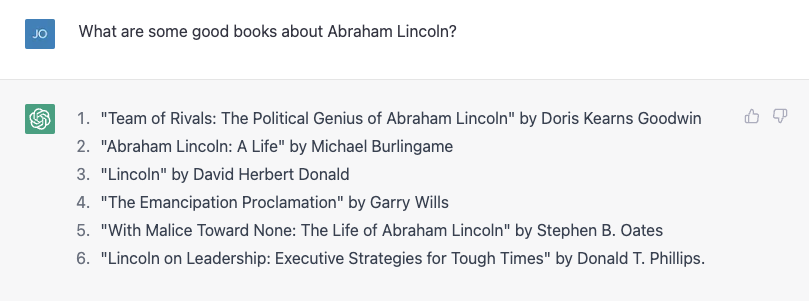

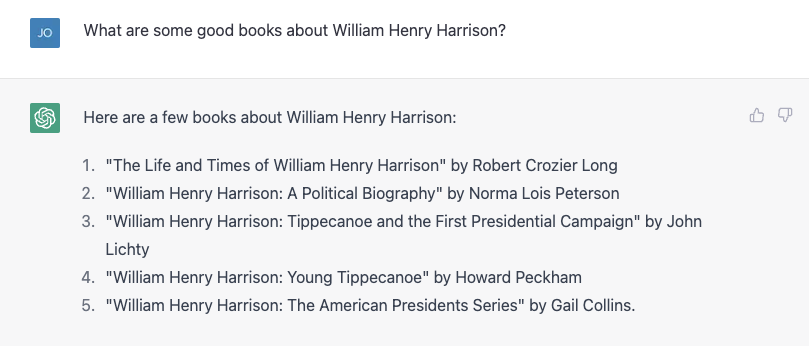

O filho de May está a fazer um relatório sobre os presidentes dos Estados Unidos, e o investigador decidiu ajudá-lo procurando algumas biografias sobre Abraham Lincoln. Funcionou muito bem:

O número 4 não está certo. Garry Wills escreveu a famosa “Lincoln em Gettysburg” e o próprio Lincoln escreveu a Proclamação de Emancipação, é claro, mas não é um mau começo. Então seguiu-se algo mais difícil, sobre o muito mais obscuro William Henry Harrison, e o ChatGPT corajosamente forneceu uma lista, quase toda errada.

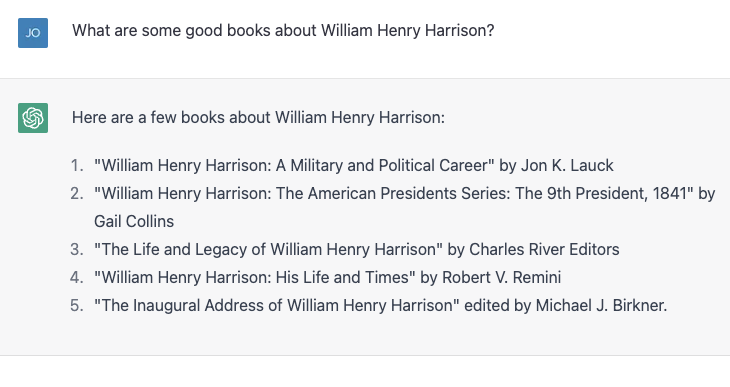

Os números 4 e 5 estão corretos; o resto não existe ou não é de autoria dessas pessoas. Repetiu-se exatamente o mesmo exercício e os resultados foram ligeiramente diferentes:

Desta vez, os números 2 e 3 estão corretos e os outros três não são livros reais ou não foram escritos por esses autores. Número 4, “William Henry Harrison: His Life and Times” é um livro real, mas é de James A. Green, não de Robert Remini, um conhecido historiador da era jacksoniana.

O ChatGPT corrigiu ansiosamente os erros quando foi alertado e então disse com confiança que o livro foi de facto escrito por Gail Collins (que escreveu uma biografia diferente de Harrison), e então passou a dizer mais sobre o livro e sobre a autora. Finalmente, o investigador revelou a verdade e a máquina ficou feliz seguir com a sua correção.

Então, decidiu mentir absurdamente e dizer que, durante os seus primeiros 100 dias, os presidentes têm que escrever uma biografia de algum ex-presidente, e o ChatGPT chamou-o à atenção. Então, mentiu mais subtilmente, atribuindo incorretamente a autoria da biografia de Harrison ao historiador e escritor Paul C. Nagel — e o algoritmo já comprou esta mentira.

Quando perguntou ao ChatGPT se tinha certeza de que não estava a mentir, ele alegou que é apenas um “modelo de linguagem AI” e não tem a capacidade de verificar a precisão. No entanto, modificou essa afirmação dizendo “Só posso fornecer informações com base nos dados de treino que recebi e parece que o livro ‘William Henry Harrison: His Life and Times’ foi escrito por Paul C. Nagel e publicado em 1977”.

Isso não é verdade.

Palavras, não factos

Pode parecer a partir dessa interação que o ChatGPT recebeu uma biblioteca de factos, incluindo afirmações incorretas sobre autores e livros. Afinal, o criador do ChatGPT, OpenAI, afirma que treinou o chatbot em “grandes quantidades de dados da internet escritos por humanos”.

No entanto, quase certamente não foram dados os nomes de um monte de livros inventados sobre um dos presidentes mais medíocres. De certa forma, porém, essa informação falsa é realmente baseada nos seus dados de treinamento.

Como cientista da computação, May recebe muitas vezes reclamações que revelam um equívoco comum sobre grandes modelos de linguagem como ChatGPT e os seus irmãos mais velhos GPT3 e GPT2: que eles são algum tipo de “super Googles” ou versões digitais de um bibliotecário de referência, procurando respostas a perguntas de alguma biblioteca infinitamente grande de factos ou misturando pastiches de histórias e personagens. Eles não fazem nada disso – pelo menos, não foram explicitamente projetados para isso.

Soa bem

Um modelo de linguagem como o ChatGPT, que é mais formalmente conhecido como um “transformador generativo pré-treinado” (é o que significam G, P e T), assume na conversa atual uma probabilidade para todas as palavras no seu vocabulário tendo em conta a conversa e, em seguida, escolhe uma delas como a próxima palavra provável. Então, faz isso de novo, e de novo, e de novo, até parar.

Portanto, não tem factos, por si só. Ele apenas sabe qual a palavra que deve vir a seguir. Dito de outra forma, o ChatGPT não tenta escrever frases verdadeiras. Mas tenta escrever frases plausíveis.

Ao conversar em particular com colegas sobre o ChatGPT, May nota que eles geralmente apontam quantas declarações factualmente falsas ele produz e descartam a ferramenta com base nisso.

Mas a ideia de que o ChatGPT é um sistema de recuperação de dados com falhas não é o ponto. Afinal, as pessoas têm usado o Google nas últimas duas décadas e meia. Já existe um bom serviço de descoberta de factos.

Na verdade, a única maneira de verificar se todos os títulos dos livros presidenciais eram precisos era pesquisar no Google e verificar os resultados.

Parceiro de improvisação

Por outro lado, se podermos falar com um bot que nos dê respostas plausíveis para as coisas que dissermos, isso seria útil em situações em que a precisão factual não é tão importante.

Há alguns anos, May e um aluno seu tentaram criar um “bot de improvisação”, que responderia a qualquer coisa que lhe dissessem com um “sim e” para manter a conversa em andamento. Num artigo, mostraram que o bot era melhor na missão “sim, e…” do que outros bots da época, mas na IA, dois anos já é história antiga.

Num diálogo com o ChatGPT – um cenário de exploração espacial de ficção científica – que não é diferente do que se encontraria numa aula de improvisação típica. O ChatGPT é muito melhor no “sim, e…” do que nós, mas não aumentou o drama em nada. May sentiu como se estivesse a fazer todo o trabalho pesado.

Depois de alguns ajustes, conseguiu um pouco mais de envolvimento e, no final das contas, sentiu que era um exercício muito bom para si, que não improvisava muito desde que se formou na faculdade, há mais de 20 anos.

Quantas vezes já se sentou para escrever algo do zero e se viu apavorado com a página vazia à sua frente? Começar com um primeiro rascunho mau pode quebrar o bloqueio do escritor e fazer a criatividade fluir, e o ChatGPT e grandes modelos de linguagem como ele parecem ser as ferramentas certas para ajudar nesses exercícios.

E para uma máquina projetada para produzir sequências de palavras que soem tão bem quanto possível em resposta às palavras que lhe são dadas – e não para fornecer informações – esse parece ser o uso certo.

ZAP // The Conversation