Uma equipa de cientistas realizou um estudo no qual algoritmos são ensinados a perceber emoções, apenas com base na forma como caminhamos. A Inteligência Artificial, através da observação de vídeos, consegue entender como nos sentimos.

Uma equipa de investigadores da Universidade da Carolina do Norte e da Universidade de Maryland desenvolveu um modelo que identifica os sentimentos dos humanos tendo em conta a forma como caminham.

Segundo o trabalho de pesquisa, pré-publicado há uma semana no arXiv, o modelo pode adivinhar quatro emoções diferentes: felicidade, tristeza, raiva e neutralidade, com 80% de rigor. A abordagem levou a uma melhoria de cerca de 14% em relação a outros métodos de reconhecimento de emoções baseados na forma de caminhar das pessoas.

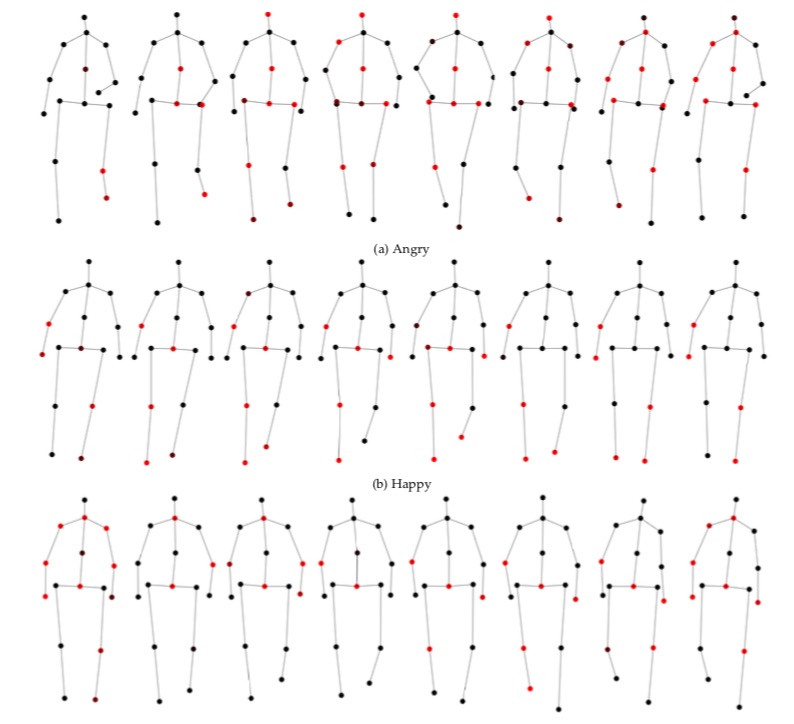

O software pode analisar um vídeo de alguém a andar, transformá-lo num modelo 3D e extrair o movimento. Depois, uma rede neural determina o movimento dominante e como este corresponde a um sentimento específico, com base nos dados em que este é ensinado.

“As emoções desempenham um papel fundamental nas nossas vidas, definindo as nossas experiências e moldando a forma como vemos o mundo e interagimos com outros seres humanos”, explica Tanmay Randhavane, um dos investigadores, à Tech Explore.

“Por exemplo, as pessoas comunicam de forma muito diferente com alguém que prevêm que está zangado e hóstil, do que com alguém que percebem estar calmo e contente”, acrescenta.

Embora já exista Inteligência Artificial (IA) treinada para perceber como os humanos se sentem, – com base nas expressões faciais ou até mesmo, pelo tom de voz -, esta é a primeira vez que um algoritmo é treinado para perceção, com rigor, através da observação de alguém a caminhar.

De acordo com a Tech Explore, estudos anteriores sugerem que a linguagem corporal, como a postura e certos movimentos, podem também dizer muito sobre como alguém se está a sentir.

Aniket Bera, supervisor do estudo, afirma que as ferramentas de reconhecimento de emoções pode, em breve, ajudar a desenvolver robôs mais avançados. Sugere que este modelo pode também vir a ser aplicado na indústria de animação, para auxiliar na criação de personagens virtuais que expressem sentimentos.

Contudo, a precisão do algoritmo depende da exatidão da estimativa 3D das poses humanas, bem como do rigor do algoritmo de extração de marcha, o que coloca limitações ao método.

A previsão de emoções pode não ser rigorosa se os movimentos das pessoas, estimados em 3D, tiverem ruído visual. O cálculo do modelo requer posições conjuntas de todo o corpo, mas os dados do posicionamento do corpo inteiro podem não estar disponíveis se existir, por exemplo, algum acessório (como uma mala ou um telemóvel).

Numa pesquisa futura, a equipa quer recolher mais dados e resolver este problema. Ambicionam estender a sua metodologia, para considerar atividades como a corrida e a gesticulação. Desejam também combinar esta abordagem com outros algoritmos de identificação de emoções, como os que usam a fala humana e as expressões faciais.