Proliferação de imagens falsas criadas por Inteligência Artificial parece ser a mais recente fonte de desinformação nas Redes Sociais.

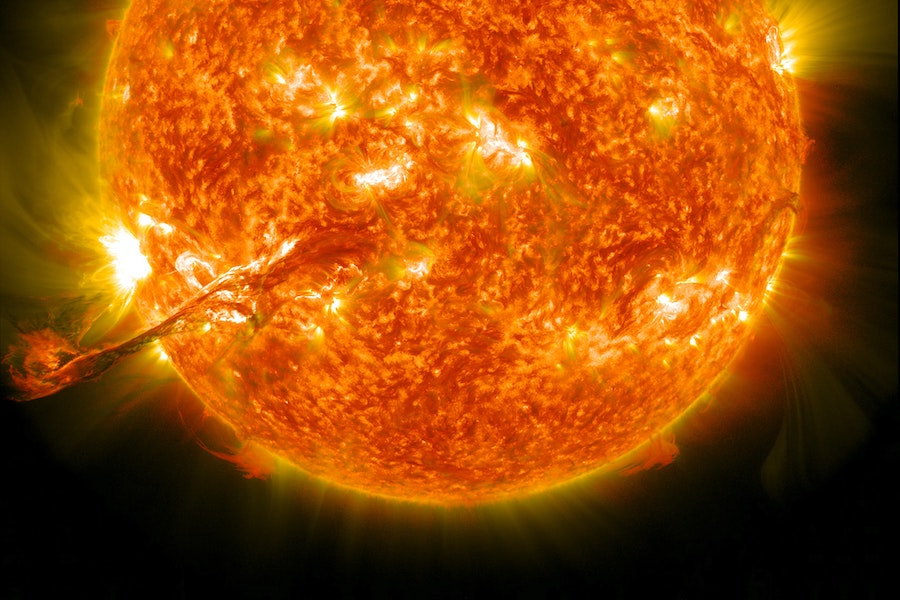

Ao longo das últimas semanas, os cantos mais escondidos do Reddit foram inundados de imagens relativas a momentos como “O infame Incidente da Peste Azul” que ocorreu na década de 1970 na União Soviética, a “enorme tempestade solar e o apagão de julho de 2012” que ocorreram nos Estados Unidos da América ou o “Grande Cascadia” um terramoto seguido de tsunami que atingiu a costa ocidental da América do Norte.

Não se tratavam de imagens soltas, já que estavam acompanhadas de descrições que davam um contexto histórico dos eventos, mas também do que se seguiu, como conferências de imprensa ou a limpeza dos danos causados. No entanto, há uma informação a considerar: nenhum destes acontecimentos ocorreu e as imagens são geradas com recurso a Inteligência Artificial (IA), nomeadamente ao programa Midjourney que transforma texto em imagem.

A tecnologia tem ainda a capacidade de dotar as imagens de um aspeto característico de determinada época ou estilo (como fotojornalismo) e incluir os rostos de personalidades (como Barack Obama). O que torna tudo mais perigoso. De facto, os internautas foram rápidos a reagir e a apontar para a possibilidade de a ferramenta vir a ser usada na difusão de teorias da conspiração para espalhar informação histórica falsa.

Sucede que este era o principal objetivo do autor de muitas das imagens, gozar com os conspiracionistas.

“Neste momento, as conspirações são populares porque tudo isto é apenas conversa entre pessoas com os mesmos sentimentos e muitas vezes ignorantes. Atirar-lhes estas coisas à cara é, essencialmente, ridicularizá-las, o que penso que, de facto, as vai acalmar. Acredito plenamente que quanto mais pessoas visualizarem as conspirações, menos pessoas acreditarão nelas.”

A intenção até podia ser boa, mas a verdade é que já há pessoas a acreditar na veracidade das imagens. Exemplo disso é a controvérsia gerada por uma imagem falsa do Papa Francisco com um casaco tipo quispo branco que acabou no Twitter, onde muitos utilizadores pensavam que era verdadeira.

Outro exemplo claro é das imagens falsas da detenção de Donald Trump (outro evento que não aconteceu). Certo é que a detenção foi dada como iminente por diversos meios de comunicação em todo o mundo, mas não chegou a concretizar-se.

Agora, os especialistas em redes sociais e programas de IA estão focados em adotar ferramentas e formas de controlar a difusão de desinformação, sem que tal não comprometa o uso das tecnologias.

De acordo com a Vice, apesar das imagens geradas terem um elevado nível de realismo é possível detetar que estas são falsas caso se olhe com atenção — no caso das imagens de Trump, os detalhes reveladores estão nas mãos e nas caras, ligeiramente distorcidas.

Curiosamente, o TikTok anunciou que todo o conteúdo deepfake ou manipulado que retrate cenas realistas seria apresentado como falso ou alterado. Simultaneamente, o uso de deep fakes de celebridades para ilustrar conteúdo político ou comercial também não será permitido. No que respeita às outras redes sociais, ainda não existem diretrizes concretas.

À velocidade com que a IA evolui parece que não vai ser fácil desenvolver regulamentos a fim de travar consequências negativas. Mas dadas as consequências que daqui podem resultar, valerá certamente o esforço.

O titulo da notícia está errado. Quem está a criar as noticias falsas são os seres humanos, usando a IA