ZAP // Dall-E-2

A batalha entre o ser humano e a IA parece não ter fim à vista. Uma nova ferramenta para envenenamento de dados promete proteger os direitos autorais dos artistas que tem visto o seu trabalho ser usado de forma indiscriminada pelos algoritmos da IA.

Imagine que precisa de uma imagem de um balão e recorre a um gerador de texto -imagem, como o Midjourney ou o DALL-E para a criar.

Insere a descrição pretendida, como por exemplo “balão vermelho contra o céu azul”, e o gerador entrega-lhe a imagem de um ovo. Ou a imagem de uma melancia.

Este resultado disparatado está a tornar-se numa realidade e a culpa é do envenenamento de dados.

Os geradores de texto para imagem são treinados por um grande conjunto de dados, que inclui milhões, se não mesmo biliões de imagens.

Alguns geradores, como os oferecidos pela Adobe ou Getty, são treinados com imagens cuja licença de utilização está na posse do fabricante.

No entanto, isto não é regra. Alguns geradores são treinados para copiar indiscriminadamente imagens online, algumas das quais protegidas por direitos de autor. Isto tem levado a uma série de casos de violação de direitos autorais, em que vários artistas acusam a tecnologia de roubar e lucrar com o seu trabalho.

Para combater esta apropriação, os cientistas criaram uma ferramenta que permite “envenenar os dados” e capacitar os artistas na sua luta pelos seus direitos autorais. Esta nova ferramenta, designada por Nightshade, promete lutar contra a utilização de imagens não autorizadas da internet.

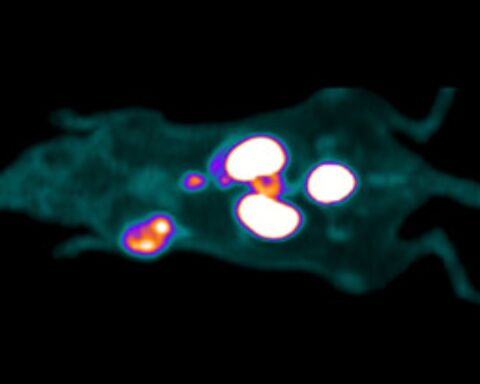

Para tal, esta ferramenta, que foi apresentada num artigo pré-publicado no arXiv, altera os pixels da imagem de uma forma muito subtil, causando estragos na imagem computacional sem, no entanto, alterar a imagem vista a olho humano.

Se estas imagens forem extraídas para treinar um modelo de IA, o seu pool de dados ficará automaticamente “envenenado”. Isto fará com que o algoritmo aprenda de forma errada e que classifique uma imagem com algo que o ser humano saberá logo ser falso.

Como resultado, o gerador poderá começar a oferecer resultados imprevisíveis e não intencionais.

É assim que uma simples imagem de um balão se poderá tornar numa imagem de um ovo. Mais isto poderá ser ainda mais grave. Imagine que pede uma imagem em estilo Monet e o sistema lhe oferece uma imagem ao estilo de Picasso.

Quanto maior for o número de imagens “envenenadas” no treino do algoritmo, maior serão os danos. E devido à forma como a IA generativa funciona, estes danos causados por imagens “envenenadas” poderão também afetar as palavras-chave relacionadas com o prompt.

Isto significa que, se uma imagem “envenenada” de um Ferrari por utilizada para treinar o algoritmo, este poderá oferecer resultados falsos para uma série de termos relacionados, como veículo, automóvel, etc.

O autor do Nightshade espera que esta ferramenta obrigue as grandes empresas de tecnologia a respeitar os dados autorais e incentiva os próprios usuários a carregar intencionalmente imagens envenenadas.

Como resposta a esta ameaça, as partes interessadas propuseram uma série de soluções tecnológicas e humanas. A mais óbvia é prestar mais atenção à origem dos dados de entrada e à forma de como estes poderão ser utilizados.

Outras soluções incluem o uso de “modelagem de conjunto” em que os diferentes modelos são treinados em muitos subconjuntos diferentes de dados e comparados entre si, para localizar valores discrepantes específicos. Esta abordagem poderá ser utilizada não apenas para o treino, mas também para detetar e descartar imagens suspeitas de envenenamento.

Outra opção poderão ser as auditorias. Poderá desenvolver-se uma abordagem de auditoria em que se realizaria um teste com um conjunto de dados pequeno, altamente selecionado e bem rotulado, resistente a “envenenamento” e que nunca seria usado para treino. Este conjunto de dados poderia ser usado para fazer auditorias a uma determinada ferramenta.

Ativistas dos direitos humanos têm-se preocupado com o uso indiscriminado da visão mecânica na sociedade em geral, especialmente nas ferramentas de reconhecimento facial.

Sistemas como o Clearview AI hospedam um enorme banco de dados pesquisável de rostos humanos extraídos da internet. Esta ferramenta é inclusive utilizada por agências policias e governamentais em todo o mundo. O governo australiano determinou, em 2021, que o Clearview AI violou a privacidade dos australianos.

Os responsáveis pelas ferramentas de IA consideram que o envenenamento de dados é um problema que precisa de ser resolvido com soluções tecnológicas.

No entanto, talvez o envenenamento de dados seja a própria solução tecnológica para a intrusão nos direitos fundamentais dos artistas e utilizadores.