The Matrix

Um gémeo digital é uma cópia de uma pessoa, produto ou processo que é criada usando dados. Isto pode soar a ficção científica, mas alguns acreditam que é provável que tenhamos um duplo digital na próxima década.

Enquanto uma cópia de uma pessoa, um gémeo digital poderia — idealmente — tomar as mesmas decisões que tomaríamos se fossemos postos nos mesmos cenários. Isto pode parecer mais uma crença especulativa dos futuristas. Mas é muito mais possível do que as pessoas gostariam de acreditar.

Apesar de acharmos que somos especiais e únicos, com uma quantidade suficiente de informação, a inteligência artifical (IA) pode fazer muitas inferências sobre as nossas personalidades, comportamentos sociais e decisões de compras.

A era de muitos dados significa que quantidades vastas de informação são recolhidas sobre as nossas atitudes e preferências evidentes, assim como traços comportamentais que deixamos para trás.

Igualmente chocante é a dimensão em que as organizações recolhem os nossos dados. Em 2019, a Walt Disney comprou a Hulu, uma empresa que os jornalistas e ativistas lembraram que tem um histórico questionável sobre a recolha de dados.

Aplicações aparentemente benignas, como as que são usadas para se encomendar café, podem recolher vastas quantidades de dados dos utilizadores em poucos minutos.

O escândalo da Cambridge Analytica ilustra estas preocupações, com os utilizadores e reguladores preocupados com a prospeção de alguém conseguir identificar, prever e mudar o seu comportamento.

Mas quão preocupados devemos estar?

Fidelidade alta vs baixa

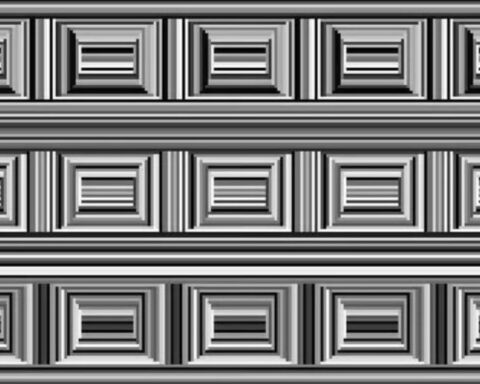

Nos estudos de simulações, a fidelidade refere-se à proximidade de uma cópia ou modelo ao seu original. A fidelidade dos simuladores refere-se ao nível de realismo de uma simulação às suas referências no mundo real.

Por exemplo, um videojogo de corrida dá uma imagem que aumenta e reduz de velocidade quando carregamos nos botões do comando ou do teclado. Já um simular de condução tem um pára-brisas, um chassis, uma manete de mudanças e pedais de aceleração e travão e é mais fiel do que um videojogo.

Um gémeo digital requere um nível alto de fidelidade que poderia incorporar informação do mundo real em tempo real: se está a chover agora, estaria a chover no simulador.

Na indústria, gémeos digitais têm duas implicações radicais. Se conseguirmos modelar um sistema de uma interação entre humano e máquina, temos a capacidade de alocar recursos, antecipar a escassez e separações e fazer projeções.

Um gémeo digital humano incorporaria uma quantidade vasta de dados sobre as preferências de uma pessoa, os seus preconceitos e comportamentos e conseguiria ter informação sobre o seu ambiente físico e social imediato para fazer previsões.

Estas exigências significam que conseguir um verdadeiro gémeo digital é uma possibilidade remota no futuro próximo. A quantidade de sensores precisa para se acumular os dados e capacidade de processamento necessários para se manter um modelo virtual do utilizador seria vasta. No presente, quem os desenvolve fica-se por modelo de baixa fidelidade.

Problemas éticos

Produzir um gémeo digital levanta questões sociais e éticas sobre a integridade dos dados, a precisão das previsões dos modelos, as capacidades de vigilância precisas para se criar e atualizar um gémeo digital e a posse e acesso a um gémeo digital.

O primeiro-ministro britânico Benjamin Disraeli é frequentemente citado dizendo: “Há três tipos de mentiras: as mentiras, as malditas mentiras e as estatísticas“, insinuando que os números não são confiáveis.

Os dados recolhidos sobre nós dependem da análise de estatísticas sobre os nossos comportamentos e hábitos que façam previsões sobre como reagiríamos em certas situações. Estes sentimentos refletem um mal-entendido sobre como os estatísticos recolhem e interpretam os dados, mas levantam uma questão importante.

Um dos problemas éticos mais importantes com os gémeos digitais relacionam-se com a falácia quantitativa, que assume que os números têm um significado objetivo divorciado do seu contexto.

Quando olhamos para números, frequentemente esquecemos que têm significados específicos que vêm dos instrumentos de medição usados para a sua recolha. E um instrumento de medição pode funcionar num contexto e não funcionar noutro.

Quando recolhemos e usamos dados, temos de reconhecer que a seleção inclui determinadas caraterísticas e não outras. Frequentemente, esta seleção é feita devido à sua conveniência ou devido às limitações práticas da tecnologia.

Devemos ser críticos de quaisquer alegações baseadas em dados e inteligência artificial porque as decisões do design não nos são disponibilizadas. Temos de entender como os dados foram recolhidos, processados, usados e apresentados.

Desequilíbrios de poder

O desequilíbrio de poder é uma discussão crescente no público, em relação aos dados, à privacidade e à vigilância.

Em escalas mais pequenas, isto pode produzir ou aumentar as divisões digitais — a lacuna entre aqueles que têm e não têm acesso a tecnologias digitais. Em escalas maiores, isto ameaça um novo colonialismo sob a premissa do acesso e do controlo da informação e da tecnologia.

Até a criação de gémeos digitais de baixa fidelidade gera uma oportunidade para se monitorizar os utilizadores, fazer inferências sobre os seus comportamentos, fazer tentativas para os influenciar e representá-los perante outros.

Apesar de isto poder ajudar em contextos de saúde ou educação, a falha em dar aos utilizadores a capacidade de aceder aos seus dados pode ameaçar a autonomia individual e bem coletivo da sociedade.

Os titulares dos dados não têm acesso aos mesmos recursos que as grandes corporações e governos. Falta-lhes tempo, treino e talvez, motivação. Há uma necessidade de vigilância consistente e independente para se garantir que os nossos direitos digitais são preservados.

ZAP // The Conversation