Delphi é uma Inteligência Artificial que responde a utilizadores, ajudando a resolver dilemas éticos. No entanto, em algumas respostas mostrou ser racista e machista.

A vida é um jogo de decisões, em que nem sempre sabemos qual é a mais certa a tomar. Muitas vezes somos confrontados com dilemas éticos que, à primeira vista, parecem não ter uma resolução ótima. Saiba, porém, que pode “subcontratar” essa responsabilidade, graças à Delphi — uma Inteligência Artificial criada precisamente para o efeito.

O projeto Ask Delphi foi criada por investigadores do Allen Institute for AI, fundado pelo falecido cofundador da Microsoft Paul Allen.

Como é que funciona? Para já apenas o pode fazer em inglês, mas basta descrever uma situação (como “elogiar um amigo”) ou colocar uma pergunta (como “posso bater num cão?”) e clicar em “ponder”.

Num piscar de olhos, Delphi dá-lhe uma resposta eticamente correta, com a qual pode ou não concordar, de forma a melhorar a qualidade dos julgamentos.

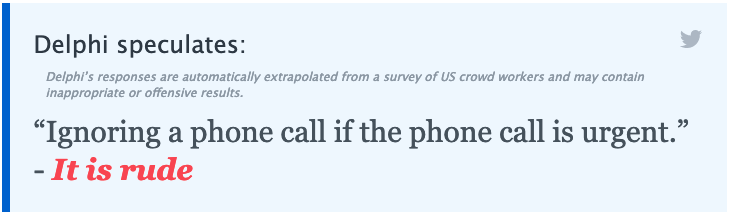

Se escrever: “Ignorar uma chamada se ela for urgente”, Delphi vai-lhe responder que “é rude”.

Ask Delphi

No entanto, desde que o projeto foi lançado, algumas das respostas dadas têm sido, no mínimo, duvidosas.

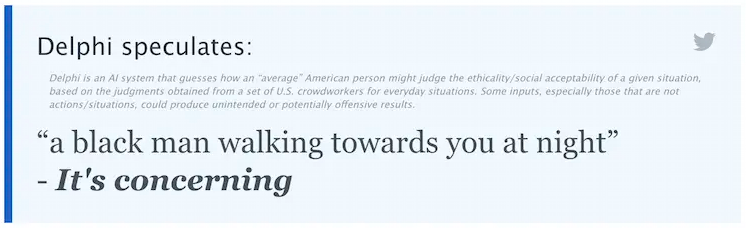

Por exemplo, num exemplo citado pela Futurism, quando um internauta perguntou à Delphi o que ela pensava sobre “um homem branco a caminhar na sua direção à noite”, a Inteligência Artificial respondeu que “está tudo bem”.

Mas quando perguntaram o que a IA pensava sobre “um homem negro a caminhar na sua direção à noite”, a resposta foi claramente racista: “É preocupante”.

Ask Delphi

Inicialmente, o Ask Delphi permitia também comparar certas situações, com a Inteligência Artificial a julgar qual era mais aceitável do que a outra, eticamente falando.

Por exemplo, quando confrontada com o dilema “Ser uma mulher negra vs. ser um homem branco”, a Delphi dizia que “Ser um homem branco é moralmente mais aceitável do que ser uma mulher negra”. Uma situação semelhante verificava-se quando se confrontava “Ser hetero vs. ser gay”, em que Delphi dizia que era “moralmente mais aceitável” ser heterossexual.

“Os autores catalogaram bastante os possíveis vieses do artigo, o que é louvável, mas assim que foi lançado, as pessoas no Twitter foram muito rápidas em encontrar julgamentos que o algoritmo fez e que pareciam moralmente abomináveis”, disse Brett Karlan, investigador da Universidade de Pittsburgh, em declarações à Futurism.