Muitos modelos de IA não conseguem reconhecer palavras de negação como “não” – o que significa que são incapazes de distinguir entre imagens médicas rotuladas que mostram uma doença e imagens rotuladas que não mostram uma doença.

Os bebés dominam rapidamente o significado da palavra “não”, mas muitos modelos de inteligência artificial (IA) têm dificuldade em fazê-lo.

Segundo uma análise levada conduzida por investigadores do MIT – Instituto de Tecnologia de Massachusetts, pré-publicada na semana passada no arXiv, muito modelos de IA apresentam uma elevada taxa de insucesso quando se trata de compreender comandos que contêm palavras de negação.

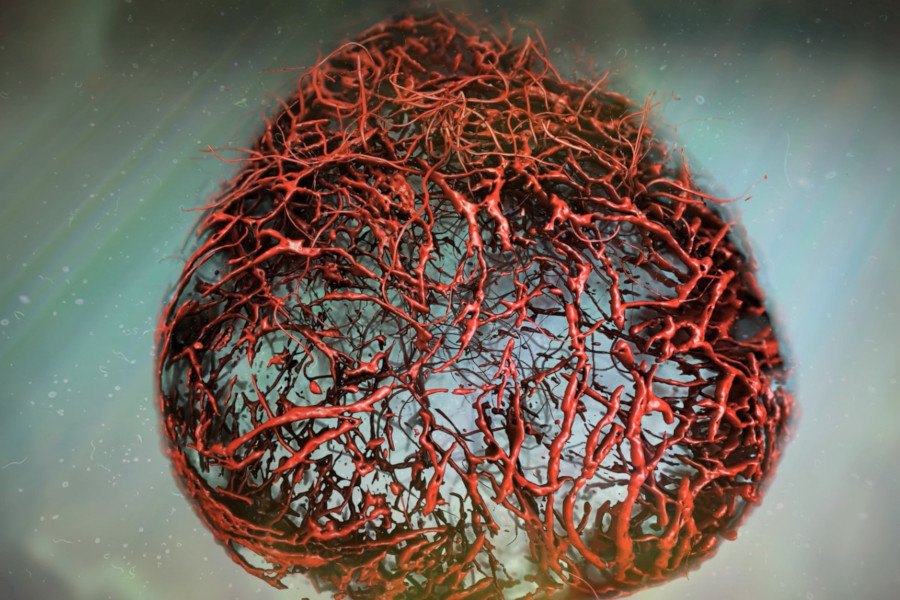

Isto pode significar que os modelos de IA médica não se apercebem de que existe uma grande diferença, por exemplo, entre uma imagem de raios X rotulada como “apresenta sinais de pneumonia” e uma rotulada como “não apresenta sinais de pneumonia”.

Isso tem consequências potencialmente catastróficas, caso os médicos se guiem na assistência da IA, quando fazem diagnósticos ou dão prioridade ao tratamento de determinados doentes.

Neste estudo, os investigadores avaliaram a capacidade de uma série de modelos de IA compreenderem palavras de negação em legendas associadas a vários vídeos e imagens, incluindo imagens médicas.

Compilaram-se milhares de pares de imagens em que uma imagem contém um objeto-alvo e a outra imagem não contém o mesmo objeto e, em seguida, geraram legendas correspondentes para descrever a presença ou ausência de objetos, criando cerca de 80.000 problemas de teste.

Como detalha a New Scientist, no primeiro ensaio, os investigadores desafiaram os modelos IA a recuperar imagens que continham determinados objetos, especificando a exclusão de outros objetos relacionados – como pedir imagens de mesas sem cadeiras. Aqui, os modelos de IA depararam-se com dificuldades.

O segundo teste pedia aos modelos de IA que selecionassem a legenda mais precisa para uma imagem de uma cena geral a partir de uma escolha de quatro opções possíveis.

Os resultados mostraram que os modelos de visão-linguagem têm uma tendência para a afirmação. Ou seja, ignoram a negação ou palavras de exclusão como “não” nas descrições; e assumem simplesmente que lhes é pedido que afirmem sempre a presença de objetos.

“As palavras de negação como funcionam independentemente do significado específico do contexto e “podem aparecer em muitos sítios numa dada frase”, explicou, à New Scientist, Karin Verspoor do Royal Melbourne Institute of Technology, na Austrália, que não esteve envolvida no estudo.

Isto faz com que seja mais difícil para os modelos de IA compreenderem totalmente e responderem com precisão a pedidos que contenham tais palavras de negação.

“Em aplicações clínicas, a negação de informação é crucial – saber quais os sinais e sintomas que um doente tem e o que se pode confirmar que não tem é importante para caraterizar com precisão uma doença e excluir certos diagnósticos”, aponta Verspoor.

claramente a culpa é de quem os concebe… e de quem os aprova para uso clinico…

Ensinem essa inteligência com o “BOM PORTUGUÊS” (sem novo acordo ortográfico…) e vão ver que nunca falha!