Através de inteligência artificial, os computadores têm melhorado cada vez mais a criação de imagens realistas de rostos humanos.

Um novo estudo, publicado a semana passada na revista académica Proceedings of the National Academy of Sciences, confirma quão convincentes podem ser as “caras” produzidas pela inteligência artificial.

Segundo a Interesting Engineering, foi pedido a mais de 300 participantes da investigação que determinassem se a imagem fornecida era uma fotografia de uma pessoa real ou uma falsificação gerada por IA — os participantes acertaram menos de metade das vezes.

Embora os investigadores acreditem que este feito “deve ser considerado um sucesso nos campos da computação gráfica e da visão”, também “encorajam aqueles que desenvolvem estas tecnologias a considerar se os riscos associados são maiores do que os seus benefícios”.

Citam perigos que vão desde campanhas de desinformação até à criação não-consensual de pornografia sintética.

“Desincentivamos o desenvolvimento desta tecnologia simplesmente porque é possível”, argumentam os investigadores.

Os investigadores por detrás do estudo partiram de 400 rostos sintéticos, gerados por um programa de código aberto de IA, feito pela gigante tecnológica NVIDIA.

O programa é o que se chama uma GAN, ou Rede Adversária Generativa, que usaa um par de redes neurais para criar as imagens. O “gerador” começa por criar uma imagem completamente aleatória. O “discriminador” utiliza um enorme conjunto de fotos reais para dar feedback ao gerador.

À medida que as duas redes neurais vão e voltam, o gerador melhora de cada vez, até o “discriminador” não conseguir distinguir as imagens reais das falsas. Ao que parece, os humanos não são melhores.

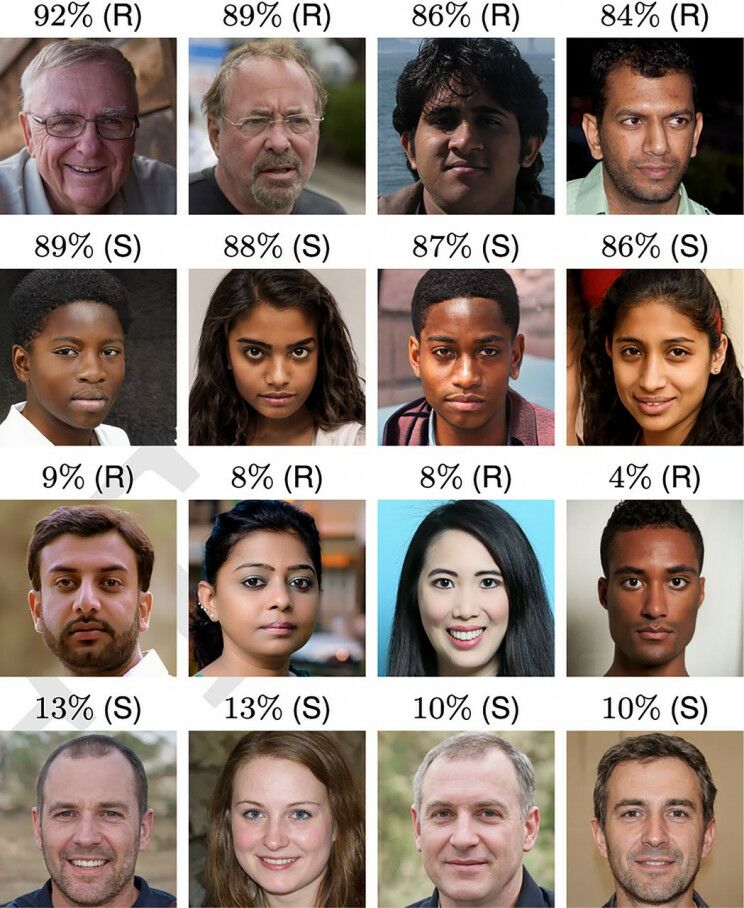

As faces classificadas com mais ou menos precisão, reais (R) e sintéticas (S)

Três experiências com resultados surpreendentes

Para realizar o estudo, os psicólogos escolheram uma amostra de género, idade e raça de 400 imagens sintéticas que a IA da NVDIA criou.

Incluiu 200 homens e 200 mulheres, com 100 rostos que se enquadravam em quatro categorias raciais: negro, branco, Ásia Oriental, e Ásia do Sul.

Para cada um desses rostos sintéticos, os investigadores escolheram uma imagem semelhante em termos demográficos, a partir dos dados do “discriminador”.

Na primeira experiência, mais de 300 participantes olharam para uma amostra de 128 rostos e disseram se achavam que cada um deles era real ou falso. Acertaram apenas 48,2 por cento das vezes.

No entanto, os participantes não tiveram a mesma dificuldade com todos os rostos. Os resultados errados ocorreram mais vezes na análise de caras brancas. — o que pode ter acontecido porque os dados da IA incluíam muito mais fotos de pessoas brancas, e mais dados equivalem a melhores renderizações.

Na segunda experiência, um novo grupo de participantes recebeu um pouco de ajuda. Antes de avaliarem as imagens, receberam um pequeno tutorial com pistas sobre como detetar um rosto gerado por um computador.

Os participantes desta segunda experiência obtiveram melhores resultados, com uma pontuação média de 59 por cento.

Na experiência final, foi pedido aos participantes que avaliassem a fiabilidade de cada uma das 128 faces, numa escala de um a sete.

Num resultado impressionante, disseram que, em média, as caras artificiais pareciam 7,7% mais fiáveis do que as caras reais.

Os investigadores chegaram à conclusão de que os rostos gerados por IA “são capazes e mais dignas de confiança — do que as caras reais”.

O impacto pode ser grande

Estes resultados apontam para um futuro com potencial para algumas situações complexas em termos de reconhecimento e memória.

Significam que “qualquer pessoa pode criar conteúdo sintético sem conhecimentos especializados de Photoshop ou CGI”, alerta Sophie Nightingale, psicóloga da Universidade de Lancaster e co-autora do estudo.

Os investigadores listam uma série de consequências negativas destas “falsificações”, praticamente indistinguíveis de imagens reais.

A tecnologia, que funciona de forma semelhante para vídeo e áudio, poderia fazer com que as campanhas de desinformação fossem bastante convincentes.

Por exemplo, na situação atual na Ucrânia, os investigadores referem a rapidez com que é possível criar um vídeo a mostrar Vladimir Putin ou Joe Biden a declarar guerra.

Poderia ser extremamente difícil convencer as pessoas de que o que viam com os seus próprios olhos não era real.

Outra grande preocupação é a pornografia sintética que mostra uma pessoa a praticar atos íntimos que, na realidade, nunca praticou.

“Talvez o mais perigoso seja a consequência de que num mundo digital em que qualquer imagem ou vídeo pode ser falsificado, a autenticidade de qualquer gravação inconveniente ou indesejável pode ser posta em causa”, concluem os investigadores.

E se isto e os deepfakes já andam no mainstream, resta imaginar a dimensão real do desenvolvimento destas tecnologias.