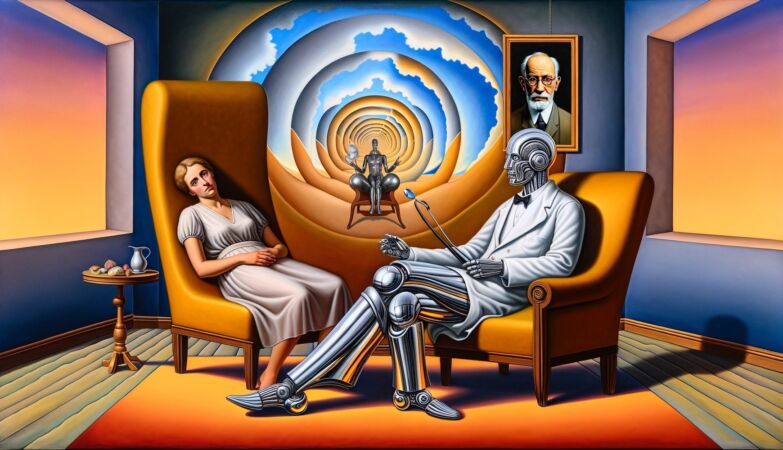

ZAP // Dall-E-2

Os chatbots de terapia são cada vez mais populares e podem beneficiar algumas pessoas. No entanto, é perigoso confiar na Inteligência Artificial durante uma crise de saúde mental.

Com a procura de cuidados a ultrapassar a oferta, os bots de apoio à saúde mental começaram a preencher esse espaço.

A maioria dos terapeutas estão completamente lotados devido ao aumento da procura de cuidados de saúde mental desde a altura da pandemia.

O Wysa, lançado em 2016, foi uma das primeiras destas plataformas digitais de apoio à saúde mental.

Desde então, centenas de concorrentes viáveis, incluindo o Woebot e o Youper, consolidaram a sua posição num mercado que lhes impõe poucas restrições.

Os bots de terapia de IA não necessitam de aprovação por parte da Food and Drug Administration (FDA), o norte-americano regulador de saúde e consumo — desde que não substituam os terapeutas humanos.

Segundo a Scientific American, em 2020, a agência reduziu os procedimentos de fiscalização para “terapêutica digital” na esperança de conter a crise psiquiátrica relacionada com a pandemia, abrindo caminho para os programadores lançarem produtos que reivindicam benefícios para a saúde mental.

Tal como outras ferramentas de IA, os chatbots de terapia apresentam diversas lacunas. As suas respostas muitas vezes não demonstram mais do que uma compreensão superficial dos problemas referidos.

Embora os atuais bots não se baseiem nos problemáticos LLM — os modelos de linguagem de grande dimensão utilizados em IA’s generativas como o ChatGPT — não há estudos que avaliem possíveis preconceitos codificados nos seus diálogos.

Não é possível saber, por exemplo, se o diálogo dos bots se pode desenrolar de forma diferente para os utilizadores de diferentes grupos raciais, de género ou sociais, conduzindo potencialmente a resultados desiguais em termos de saúde mental.

Quanto mais parecidos com os humanos e sem restrições os chatbots se tornarem, mais difícil será impedi-los de dar conselhos inadequados ou tendenciosos, o que pode levar a diversas consequências na vida de quem recorre a este tipo de ajuda.

Assim, é importante usar a IA apenas para pequenas ajudas e não como se tratasse da ajuda de humanos e psicólogos.