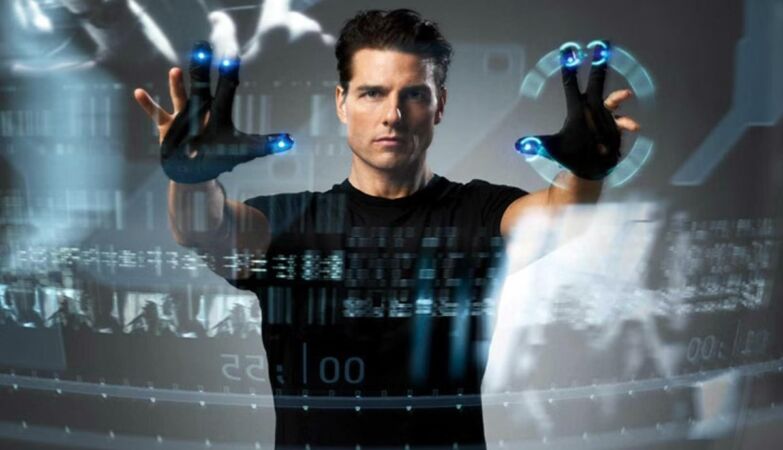

20th Century Fox

Minority Report (Steven Spielberg, 2002)

Quem tem mais probabilidade de se tornar assassino? Reino Unido vai perguntar à tecnologia. Iniciativa “arrepiante” do governo britânico, estilo “Minority Report”, ameaça ser discriminatório.

Estilo “Minority Report“, filme passado em 2054 e onde Tom Cruise é chefe da unidade policial de “Pré-Crime”, o Reino Unido prepara-se para perguntar a um algoritmo quem tem mais probabilidade de se tornar assassino.

O projeto já tem nome oficial — “Sharing Data to Improve Risk Assessment”, que substitui “Homicide Prediction Project” — e vai usar tecnologia para analisar dados de milhares (100 a 500 mil pessoas, alegadamente) de indivíduos conhecidos pelas autoridades de justiça criminal, para aumentar a segurança pública através de uma melhor avaliação dos riscos, segundo o Ministério da Justiça, mas já está a provocar o alarme, especialmente entre ativistas e a polícia, que o descrevem como “arrepiante” e “distópico”.

O novo programa do governo do Reino Unido vai usar esta ferramenta para identificar os indivíduos com maior probabilidade de cometerem homicídios.

O governo diz que são técnicas avançadas de ciência de dados como reforço das atuais ferramentas de avaliação de risco já utilizadas pelos serviços prisionais e de liberdade condicional.

Ainda estará, segundo o ministério, em fase de teste, e utiliza apenas dados de indivíduos com pelo menos uma condenação penal, mas há quem diga o contrário.

Segundo o grupo de defesa das liberdades civis Statewatch, o acordo de partilha de dados entre o Ministério da Justiça e a Polícia de Manchester (GMP) inclui informações sobre pessoas que não foram condenadas por qualquer crime, como vítimas de violência doméstica e indivíduos que se automutilaram ou tiveram problemas de saúde mental.

Aliás, o projeto estará alegadamente a usar dados de várias fontes oficiais, incluindo o Serviço de Reinserção Social e dados da GMP recolhidos ainda antes de 2015.

Estamos a falar de nomes, datas de nascimento, género, etnia e identificadores ligados a bases de dados policiais, classificados em documentos oficiais como “categorias especiais de dados pessoais”.

Estas informações incluem indicadores relacionados com a saúde, como a toxicodependência, o suicídio, as doenças mentais, as lesões autoprovocadas e a deficiência.

“Assustador e alarmante”

Muitos ativistas e investigadores lembram que a ferramenta tem o grande potencial de reforçar preconceitos sistémicos, de atingir as minorias étnicas e as comunidades com baixos rendimentos e, no geral, de reforçar a discriminação estrutural no país.

“A tentativa do Ministério da Justiça de construir este sistema de previsão de homicídios é o último exemplo assustador e distópico da intenção do governo de desenvolver os chamados sistemas de ‘previsão’ de crimes”, disse Sofia Lyall, investigadora da Statewatch

A investigação mostra repetidamente que os sistemas algorítmicos de “previsão” da criminalidade são intrinsecamente defeituosos”, avisa: “este último modelo, que utiliza dados da nossa polícia e do nosso Ministério do Interior, institucionalmente racistas, irá reforçar e ampliar a discriminação estrutural subjacente ao sistema jurídico-penal”.

“À semelhança de outros sistemas do género, este codificará o preconceito em relação às comunidades racializadas e de baixos rendimentos. Construir uma ferramenta automatizada para definir o perfil das pessoas como criminosos violentos é profundamente errado, e utilizar dados tão sensíveis sobre saúde mental, dependência e deficiência é altamente intrusivo e alarmante.”

A verdade é que estes algoritmos não são justos por natureza: baseiam-se na probabilidade estatística, e não no comportamento real.

São muitos os casos conhecidos que envolveram a aplicação de tecnologia e Inteligência artificial com autonomia para tomar decisões na justiça, no policiamento e na investigação criminal e que se revelaram tendenciosos, injustos e discriminatórios.

O caso de Robert Williams, negro, detido em 2020 sob falsas acusações pela Polícia de Detroit devido a uma identificação incorreta por parte de tecnologia de reconhecimento facial, vem logo à mente.

Em alguns tribunais dos EUA a discussão foi mais alargada devido ao uso do software COMPAS, usado para avaliar o risco de reincidência dos arguidos e altamente criticado por exibir claros enviesamentos raciais.

A caminharmos para algo pior que o 1984 e o Admirável Mundo Novo. Lembro-me de ter lido online algo deste género: no 1984, as pessoas tinham medo de que alguém estivesse a vê-los através do ecrã, hoje em dia têm medo de que ninguém esteja. O controlo de massas através de voyeurismo/exibicionismo tornou-se a norma, e acabou de contaminar instituições estatais.